Nhiều nguồn tin cho rằng, việc các nhà nghiên cứu của OpenAI tiệm cận đến việc có thể tạo ra AGI là nguyên nhân khiến CEO Sam Altman đột ngột bị sa thải.

OpenAI, cha đẻ của ChatGPT đã trải qua một cuối tuần đầy sóng gió, khi hội đồng quản trị công ty đột ngột sa thải CEO Sam Altman, kéo theo hàng loạt biến động trong nội bộ công ty khi vị trí CEO tạm quyền liên tục bị thay thế, còn các nhân viên đồng loạt ký thư ngỏ đòi Hội đồng quản trị phải từ chức để đưa Sam Altman trở lại vị trí CEO nếu không sẽ nghỉ việc.

Hiện tại, tình hình nội bộ của OpenAI đã phần nào ổn định khi Sam Altman đã quay trở lại vị trí CEO, Hội đồng quản trị cũ đã từ nhiệm để thành lập một Hội đồng quản trị mới. Mặc dù vậy, câu hỏi về việc tại sao Hội đồng quản trị lại đột ngột sa thải CEO Sam Altman vẫn chưa được trả lời một cách thỏa đáng.

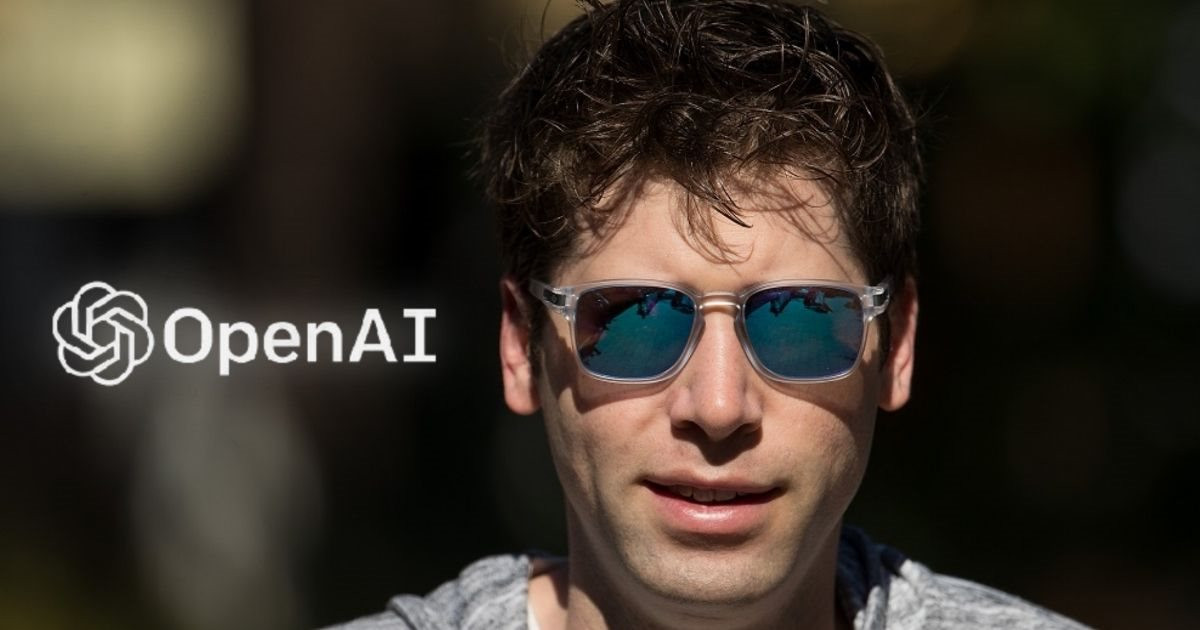

CEO OpenAI, Sam Altman, trung tâm của hỗn loạn cuối tuần qua tại công ty khai sinh ra ChatGPT

Các nguồn tin của Reuters cho biết, trước khi ra quyết định sa thải Sam Altman, Hội đồng quản trị OpenAI đã nhận được cảnh báo cho biết về một bước đột phá khi sắp tạo ra trí tuệ nhân tạo siêu thông minh, có thể gây nguy hiểm cho nhân loại. Và do các lo ngại về cách hành xử thiếu thận trọng của CEO Sam Altman, Hội đồng quản trị OpenAI đã ra một quyết định chóng vánh là sa thải ông. Nhiều người cho rằng, bước đột phá này chính là việc các nhà nghiên cứu OpenAI đã tạo ra được một AGI (artificial general intelligence hay Trí tuệ Nhân tạo Tổng quát).

Không chỉ các nhà nghiên cứu của OpenAI, nhiều học giả khác trên thế giới cũng bày tỏ sự lo ngại của mình đối với khả năng tạo ra AGI từ các hoạt động nghiên cứu trí tuệ nhân tạo của những công ty trên thế giới.

AGI - trí tuệ nhân tạo tự động có khả năng tư duy như con người

Vậy AGI là gì, nó khác gì so với những chatbot như ChatGPT, Bard, Bing Chat, … đang được các hãng công nghệ trên thế giới phát triển và đưa đến người dùng như hiện nay. Và tại sao các nhà nghiên cứu lại kinh sợ nó đến như vậy?

Cho dù chưa có một định nghĩa chính xác, nhưng nhiều chuyên gia cho biết AGI là hệ thống có khả năng tự động hoá cao và có thể thực hiện công việc có giá trị kinh tế tốt hơn cả con người. AGI không chuyên về một lĩnh vực nào cụ thể như hầu hết các hệ thống AI hiện nay. Nó có khả năng thích nghi và tổng quát hoá qua một loạt các tác vụ, cũng như có thể đạt được các kỹ năng đặc trưng của con người: đó là có ý thức và trực giác. Còn theo OpenAI, AGI được xem là một trí tuệ nhân tạo siêu thông minh và có ích cho nhân loại.

Các AGI rất khác biệt so với các chatbot đang được người dùng sử dụng phổ biến hiện nay. Về cơ bản, các chatbot như ChatGPT, Bing Chat hay Bard đều là các ứng dụng vận hành dựa trên những mô hình ngôn ngữ lớn (các LLMs). Trong khi AGI là một loại AI về lý thuyết có thể thực hiện được các tác vụ trí tuệ và có ý thức và trực giác như con người, các chatbot và các mô hình LLMs hiện nay chỉ là loại AI được huấn luyện bằng khối lượng dữ liệu khổng lồ để đưa ra các câu trả lời dựa trên những mô hình mà nó học được từ dữ liệu.

Các chuyên gia trong lĩnh vực AI đang biểu hiện sự hoài nghi về việc đạt được AGI trong tương lai gần do độ phức tạp và thách thức liên quan. Sự hoài nghi này xuất phát từ sự thiếu hiểu biết về trí tuệ ở cấp độ con người và khó khăn trong việc sao chép nó trong máy móc. Mặc dù khái niệm về AGI đã được nhiều người biết đến thông qua khoa học viễn tưởng, nhưng thực tế vẫn còn xa vời so với khả năng được mô tả.

Tại sao nhiều học giả lại e sợ AGI

Dù mới chỉ có trên lý thuyết, nhưng khả năng của AGI đã gây ra nhiều lo ngại cho các chuyên gia và học giả trong ngành. Là một hệ thống tự động hoàn toàn – thậm chí có thể tự nhận thức – AGI có thể vượt trội con người trong hầu hết công việc mang giá trị kinh tế.

Hơn thế nữa, khả năng học hỏi liên tục không biết mệt mỏi có thể sẽ làm cho công nghệ AGI trở nên thông minh hơn cả con người. Điều đó làm các chuyên gia lo ngại về những rủi ro tiềm tàng của công nghệ này khi cuối cùng chúng ta không thể kiểm soát được nó.

Ngay cả khi chưa có trí tuệ vượt trội con người, AGI cũng có thể tạo ra những tác động đáng kể đối với thị trường lao động, khi thay thế con người trong nhiều lĩnh vực. Bên cạnh đó, còn có những lo ngại liên quan đến vấn đề đạo đức trong việc phát triển AGI.

Hơn thế nữa, các chuyên gia còn lo ngại rằng các AGI còn gián tiếp đe dọa đến nhân loại theo cách khác. Kết hợp với những tiến bộ công nghệ khác, việc con người lạm dụng công nghệ AGI có thể gây ra các mối đe dọa khác đến chính nhân loại.

Chính các lo ngại này đã khiến nhiều nhà nghiên cứu AI, các chuyên gia trong lĩnh vực này cùng lên tiếng kêu gọi các tập đoàn công nghệ kiềm chế việc phát triển công nghệ trí tuệ nhân tạo cao cấp này. Tuy nhiên cuộc chạy đua phát triển AI giữa các hãng công nghệ, thậm chí giữa các quốc gia đang làm lu mờ lời kêu gọi này.

Liệu điều này có phải là nguyên nhân cho quyết định chóng vánh về việc sa thải CEO Sam Altman của OpenAI hay không? Cho đến giờ tất cả vẫn chỉ là phỏng đoán. Nhưng nếu quả thật điều đó có liên quan đến một công nghệ do công ty đang phát triển, có lẽ họ nên giải thích vì điều đó.

Trong khi bình luận về lời xin lỗi của Ilya Sutskever, nhà khoa học trưởng của OpenAI, khi cùng với Hội đồng quản trị lật đổ Sam Altman, ông Elon Musk cho biết: “Tại sao ông lại có hành động quyết liệt như vậy? Nếu OpenAI làm điều gì đó có thể gây nguy hiểm tiềm tàng cho nhân loại, thế giới cần được biết.”

OpenAI, cha đẻ của ChatGPT đã trải qua một cuối tuần đầy sóng gió, khi hội đồng quản trị công ty đột ngột sa thải CEO Sam Altman, kéo theo hàng loạt biến động trong nội bộ công ty khi vị trí CEO tạm quyền liên tục bị thay thế, còn các nhân viên đồng loạt ký thư ngỏ đòi Hội đồng quản trị phải từ chức để đưa Sam Altman trở lại vị trí CEO nếu không sẽ nghỉ việc.

Hiện tại, tình hình nội bộ của OpenAI đã phần nào ổn định khi Sam Altman đã quay trở lại vị trí CEO, Hội đồng quản trị cũ đã từ nhiệm để thành lập một Hội đồng quản trị mới. Mặc dù vậy, câu hỏi về việc tại sao Hội đồng quản trị lại đột ngột sa thải CEO Sam Altman vẫn chưa được trả lời một cách thỏa đáng.

CEO OpenAI, Sam Altman, trung tâm của hỗn loạn cuối tuần qua tại công ty khai sinh ra ChatGPT

Các nguồn tin của Reuters cho biết, trước khi ra quyết định sa thải Sam Altman, Hội đồng quản trị OpenAI đã nhận được cảnh báo cho biết về một bước đột phá khi sắp tạo ra trí tuệ nhân tạo siêu thông minh, có thể gây nguy hiểm cho nhân loại. Và do các lo ngại về cách hành xử thiếu thận trọng của CEO Sam Altman, Hội đồng quản trị OpenAI đã ra một quyết định chóng vánh là sa thải ông. Nhiều người cho rằng, bước đột phá này chính là việc các nhà nghiên cứu OpenAI đã tạo ra được một AGI (artificial general intelligence hay Trí tuệ Nhân tạo Tổng quát).

Không chỉ các nhà nghiên cứu của OpenAI, nhiều học giả khác trên thế giới cũng bày tỏ sự lo ngại của mình đối với khả năng tạo ra AGI từ các hoạt động nghiên cứu trí tuệ nhân tạo của những công ty trên thế giới.

AGI - trí tuệ nhân tạo tự động có khả năng tư duy như con người

Vậy AGI là gì, nó khác gì so với những chatbot như ChatGPT, Bard, Bing Chat, … đang được các hãng công nghệ trên thế giới phát triển và đưa đến người dùng như hiện nay. Và tại sao các nhà nghiên cứu lại kinh sợ nó đến như vậy?

Cho dù chưa có một định nghĩa chính xác, nhưng nhiều chuyên gia cho biết AGI là hệ thống có khả năng tự động hoá cao và có thể thực hiện công việc có giá trị kinh tế tốt hơn cả con người. AGI không chuyên về một lĩnh vực nào cụ thể như hầu hết các hệ thống AI hiện nay. Nó có khả năng thích nghi và tổng quát hoá qua một loạt các tác vụ, cũng như có thể đạt được các kỹ năng đặc trưng của con người: đó là có ý thức và trực giác. Còn theo OpenAI, AGI được xem là một trí tuệ nhân tạo siêu thông minh và có ích cho nhân loại.

Các AGI rất khác biệt so với các chatbot đang được người dùng sử dụng phổ biến hiện nay. Về cơ bản, các chatbot như ChatGPT, Bing Chat hay Bard đều là các ứng dụng vận hành dựa trên những mô hình ngôn ngữ lớn (các LLMs). Trong khi AGI là một loại AI về lý thuyết có thể thực hiện được các tác vụ trí tuệ và có ý thức và trực giác như con người, các chatbot và các mô hình LLMs hiện nay chỉ là loại AI được huấn luyện bằng khối lượng dữ liệu khổng lồ để đưa ra các câu trả lời dựa trên những mô hình mà nó học được từ dữ liệu.

Các chuyên gia trong lĩnh vực AI đang biểu hiện sự hoài nghi về việc đạt được AGI trong tương lai gần do độ phức tạp và thách thức liên quan. Sự hoài nghi này xuất phát từ sự thiếu hiểu biết về trí tuệ ở cấp độ con người và khó khăn trong việc sao chép nó trong máy móc. Mặc dù khái niệm về AGI đã được nhiều người biết đến thông qua khoa học viễn tưởng, nhưng thực tế vẫn còn xa vời so với khả năng được mô tả.

Tại sao nhiều học giả lại e sợ AGI

Dù mới chỉ có trên lý thuyết, nhưng khả năng của AGI đã gây ra nhiều lo ngại cho các chuyên gia và học giả trong ngành. Là một hệ thống tự động hoàn toàn – thậm chí có thể tự nhận thức – AGI có thể vượt trội con người trong hầu hết công việc mang giá trị kinh tế.

Hơn thế nữa, khả năng học hỏi liên tục không biết mệt mỏi có thể sẽ làm cho công nghệ AGI trở nên thông minh hơn cả con người. Điều đó làm các chuyên gia lo ngại về những rủi ro tiềm tàng của công nghệ này khi cuối cùng chúng ta không thể kiểm soát được nó.

Ngay cả khi chưa có trí tuệ vượt trội con người, AGI cũng có thể tạo ra những tác động đáng kể đối với thị trường lao động, khi thay thế con người trong nhiều lĩnh vực. Bên cạnh đó, còn có những lo ngại liên quan đến vấn đề đạo đức trong việc phát triển AGI.

Hơn thế nữa, các chuyên gia còn lo ngại rằng các AGI còn gián tiếp đe dọa đến nhân loại theo cách khác. Kết hợp với những tiến bộ công nghệ khác, việc con người lạm dụng công nghệ AGI có thể gây ra các mối đe dọa khác đến chính nhân loại.

Chính các lo ngại này đã khiến nhiều nhà nghiên cứu AI, các chuyên gia trong lĩnh vực này cùng lên tiếng kêu gọi các tập đoàn công nghệ kiềm chế việc phát triển công nghệ trí tuệ nhân tạo cao cấp này. Tuy nhiên cuộc chạy đua phát triển AI giữa các hãng công nghệ, thậm chí giữa các quốc gia đang làm lu mờ lời kêu gọi này.

Liệu điều này có phải là nguyên nhân cho quyết định chóng vánh về việc sa thải CEO Sam Altman của OpenAI hay không? Cho đến giờ tất cả vẫn chỉ là phỏng đoán. Nhưng nếu quả thật điều đó có liên quan đến một công nghệ do công ty đang phát triển, có lẽ họ nên giải thích vì điều đó.

Trong khi bình luận về lời xin lỗi của Ilya Sutskever, nhà khoa học trưởng của OpenAI, khi cùng với Hội đồng quản trị lật đổ Sam Altman, ông Elon Musk cho biết: “Tại sao ông lại có hành động quyết liệt như vậy? Nếu OpenAI làm điều gì đó có thể gây nguy hiểm tiềm tàng cho nhân loại, thế giới cần được biết.”

Theo Genk