Mặc dù vậy, kỹ sư này cũng cho rằng các mô hình AI mới ra mắt là bước tiến khoa học kỹ thuật lớn nhất sau khi bom nguyên tử xuất hiện.

Thế giới chắc sẽ không nhiều người biết đến mô hình AI LaMDA của Google nếu không nhờ một cựu kỹ sư của công ty, Blake Lemoine. Vào năm ngoái, mô hình AI này trở nên nổi tiếng khi cựu kỹ sư này tuyên bố nó "tri giác" – một tuyên bố đã khiến anh bị sa thải vì vi phạm chính sách bí mật của công ty.

Nhưng giờ đây, cựu kỹ sư này tiếp tục bày tỏ mối lo ngại về các chatbot AI giống như Bing AI của Microsoft. Theo Lemoine, các mô hình AI này là bước tiến công nghệ kỹ thuật quan trọng nhất kể từ khi bom nguyên tử xuất hiện và có thể làm thay đổi cơ bản tiến trình lịch sử nhân loại.

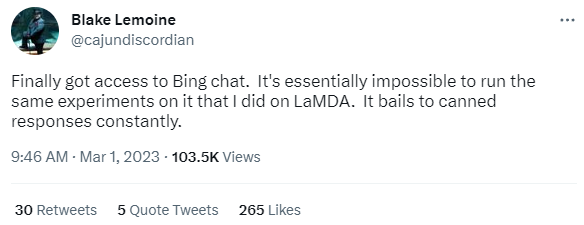

"Về cơ bản, nó không thể thực hiện được các thử nghiệm tương tự như tôi từng làm trên LaMDA của Google. Nó liên tục đưa ra các phản hồi rất tù mù." Lemoine cho biết trên Twitter sau khi thử nghiệm chatbot Bing AI của Microsoft.

Blake Lemoine. Ảnh Internet

Lemoine e sợ rằng công nghệ này có thể bị lạm dụng để phát tán thông tin sai lệch, tuyên truyền chính trị hoặc thông tin xúc phạm những người thuộc các chủng tộc và tôn giáo khác nhau.

Đoàn tàu trật bánh

Trước đó cho dù chưa được trực tiếp dùng thử Bing AI, nhưng khi trả lời phỏng vấn tạp chí Newsweek, Lemoine cho rằng, dường như chatbot của Microsoft cũng có "tri giác" giống như điều anh từng thấy trên mô hình AI của Google. Tuy nhiên, nó lại thiếu ổn định nếu so với một con người.

Dù nhiều người cho rằng, mô hình LaMDA của Google hay các chatbot khác không có "tri giác" như anh tuyên bố, nhưng anh cho rằng, "cụm từ được minh oan không hoàn toàn diễn tả được cảm giác của tôi về tình huống này".

"Bạn dự đoán sắp có đoàn tàu bị trật bánh, rồi có những người nói với bạn rằng không có đoàn tàu nào cả, và sau đó nhìn đoàn tàu đó trật bánh ngay trong thời gian thực không dẫn đến cảm giác được minh oan chút nào." Lemoine cho biết.

"Điều đó thật bi thảm."

Lemoine nhấn mạnh rằng, trước khi được phát hành ra công chúng, ông muốn thấy các mô hình AI được thử nghiệm kỹ lưỡng hơn để tìm kiếm và phát hiện rủi ro khả năng thao túng người tiêu dùng.

Lemoine cho biết: "Tôi cảm thấy công nghệ này chỉ mang tính thử nghiệm, và việc công bố nó hiện tại là vô cùng nguy hiểm." Kỹ sư này sau đó lặp lại những lời phàn nàn trước đó rằng các mô hình AI đã không trải qua quá trình thử nghiệm đầy đủ trước khi được ra mắt công chúng.

Tuy nhiên, một lão làng trong ngành công nghệ lại không nghĩ như vậy.

Các mô hình AI không phải là mối đe dọa

Gần đây, trong một cuộc phỏng vấn với Financial Times vào thứ Năm tuần trước, Bill Gates, đồng sáng lập Microsoft, đã mô tả các mô hình AI mới ra mắt gần đây như một loại "công nghệ lâu đời".

Ông nói: "Công nghệ mà hầu hết mọi người đang chơi đùa với nó hiện nay, nó lâu đời rồi."

Theo ông Gates, cho dù các chatbot AI như Bing hiện nay có thể nói ra "những điều điên rồ", nhưng chủ yếu là do con người đã cố tình khiêu khích nó khiến các chương trình này mắc lỗi.

Nhà đồng sáng lập Microsoft còn cho rằng, các mô hình AI hiện tại hoàn toàn "ổn và không gây ra mối đe dọa nào", đồng thời cho biết thêm rằng, không rõ ai sẽ là người bị đổ lỗi "nếu bạn ngồi đó và khiêu khích một chút" với người khác.

Thế giới chắc sẽ không nhiều người biết đến mô hình AI LaMDA của Google nếu không nhờ một cựu kỹ sư của công ty, Blake Lemoine. Vào năm ngoái, mô hình AI này trở nên nổi tiếng khi cựu kỹ sư này tuyên bố nó "tri giác" – một tuyên bố đã khiến anh bị sa thải vì vi phạm chính sách bí mật của công ty.

Nhưng giờ đây, cựu kỹ sư này tiếp tục bày tỏ mối lo ngại về các chatbot AI giống như Bing AI của Microsoft. Theo Lemoine, các mô hình AI này là bước tiến công nghệ kỹ thuật quan trọng nhất kể từ khi bom nguyên tử xuất hiện và có thể làm thay đổi cơ bản tiến trình lịch sử nhân loại.

"Về cơ bản, nó không thể thực hiện được các thử nghiệm tương tự như tôi từng làm trên LaMDA của Google. Nó liên tục đưa ra các phản hồi rất tù mù." Lemoine cho biết trên Twitter sau khi thử nghiệm chatbot Bing AI của Microsoft.

Blake Lemoine. Ảnh Internet

Lemoine e sợ rằng công nghệ này có thể bị lạm dụng để phát tán thông tin sai lệch, tuyên truyền chính trị hoặc thông tin xúc phạm những người thuộc các chủng tộc và tôn giáo khác nhau.

Đoàn tàu trật bánh

Trước đó cho dù chưa được trực tiếp dùng thử Bing AI, nhưng khi trả lời phỏng vấn tạp chí Newsweek, Lemoine cho rằng, dường như chatbot của Microsoft cũng có "tri giác" giống như điều anh từng thấy trên mô hình AI của Google. Tuy nhiên, nó lại thiếu ổn định nếu so với một con người.

Dù nhiều người cho rằng, mô hình LaMDA của Google hay các chatbot khác không có "tri giác" như anh tuyên bố, nhưng anh cho rằng, "cụm từ được minh oan không hoàn toàn diễn tả được cảm giác của tôi về tình huống này".

"Bạn dự đoán sắp có đoàn tàu bị trật bánh, rồi có những người nói với bạn rằng không có đoàn tàu nào cả, và sau đó nhìn đoàn tàu đó trật bánh ngay trong thời gian thực không dẫn đến cảm giác được minh oan chút nào." Lemoine cho biết.

"Điều đó thật bi thảm."

Lemoine nhấn mạnh rằng, trước khi được phát hành ra công chúng, ông muốn thấy các mô hình AI được thử nghiệm kỹ lưỡng hơn để tìm kiếm và phát hiện rủi ro khả năng thao túng người tiêu dùng.

Lemoine cho biết: "Tôi cảm thấy công nghệ này chỉ mang tính thử nghiệm, và việc công bố nó hiện tại là vô cùng nguy hiểm." Kỹ sư này sau đó lặp lại những lời phàn nàn trước đó rằng các mô hình AI đã không trải qua quá trình thử nghiệm đầy đủ trước khi được ra mắt công chúng.

Tuy nhiên, một lão làng trong ngành công nghệ lại không nghĩ như vậy.

Các mô hình AI không phải là mối đe dọa

Gần đây, trong một cuộc phỏng vấn với Financial Times vào thứ Năm tuần trước, Bill Gates, đồng sáng lập Microsoft, đã mô tả các mô hình AI mới ra mắt gần đây như một loại "công nghệ lâu đời".

Ông nói: "Công nghệ mà hầu hết mọi người đang chơi đùa với nó hiện nay, nó lâu đời rồi."

Theo ông Gates, cho dù các chatbot AI như Bing hiện nay có thể nói ra "những điều điên rồ", nhưng chủ yếu là do con người đã cố tình khiêu khích nó khiến các chương trình này mắc lỗi.

Nhà đồng sáng lập Microsoft còn cho rằng, các mô hình AI hiện tại hoàn toàn "ổn và không gây ra mối đe dọa nào", đồng thời cho biết thêm rằng, không rõ ai sẽ là người bị đổ lỗi "nếu bạn ngồi đó và khiêu khích một chút" với người khác.

Theo Genk