Không một ai dám làm mất lòng Nvidia.

Lần đầu tiên dùng thử ChatGPT, Giám đốc điều hành Nvidia Jensen Huang yêu cầu chatbot này viết một bài thơ về công ty. Kết quả vượt ngoài sự mong đợi và người đàn ông khi ấy vô cùng hài lòng vì đã liều lĩnh đặt cược vào AI.

“Nvidia hoàn thành thách thức. Với sức mạnh AI, công ty đã vượt qua được giới hạn của công nghệ”, ông Jensen Huang nói.

Trong suốt 30 năm, chip Nvidia đóng vai trò quan trọng trong việc phát triển các trò chơi điện tử, song vẫn khiến Huang nghi ngờ về khả năng sàng lọc các tập dữ liệu khổng lồ AI yêu cầu. Để kiểm tra giải thuyết này, ông hướng dẫn nhóm của mình xây dựng một máy chủ được thiết kế cho AI và giao thử nghiệm chiếc đầu tiên vào năm 2016 cho Elon Musk và Sam Altman - nhà sáng lập OpenAI.

Được quảng cáo như một siêu máy tính AI, thiết bị trị giá 129.000 USD này có kích thước bằng một chiếc cặp, chứa 8 bộ xử lý đồ họa kết nối có thể giải quyết công việc trong 2 giờ đồng hồ thay vì 6 ngày như thường lệ.

OpenAI phát hành ChatGPT vào cuối năm ngoái, với “bộ não” chứa hơn 20.000 bộ xử lý đồ họa Nvidia. Microsoft cam kết tài trợ hơn 10 tỷ USD và điều này sẽ giúp trang trải chi phí ngày càng tăng trong quá trình phát triển. Altman, Giám đốc điều hành OpenAI, sẽ cần thêm hàng tấn chip Nvidia để đáp ứng nhu cầu.

Chip Nvidia đóng vai trò quan trọng trong cơ sở hạ tầng đám mây. Các nhà khai thác trung tâm dữ liệu đã cùng nhau chi 15 tỷ USD vào năm ngoái cho các đơn đặt hàng số lượng lớn với Nvidia. Doanh thu hàng quý từ các trung tâm dữ liệu, thứ mà Nvidia hiện gọi là “nhà máy AI”, đã tăng 14% lên mức kỷ lục 4,28 tỷ USD. Dự báo doanh số cũng tăng vượt ước tính cũng giúp Nvidia chạm mốc vốn hóa 1 nghìn tỷ USD.

Theo Bloomberg, Nvidia bất ngờ trở thành “người khổng lồ” quan trọng cho công nghệ chip nhớ. Công ty sở hữu 80% thị trường chip cao cấp và thời gian chờ cho một trong những bộ xử lý AI này hiện đã lên tới 8 tháng. Một số khách hàng lớn của Huang đã phải thiết kế chip tùy chỉnh của riêng mình để giảm sự phụ thuộc vào Nvidia.

“Nvidia phải vấp ngã vì một lý do nào đó thì các đối thủ cạnh tranh mới có cơ hội”, Chris Mack, nhà phân tích tại Harding Loevner LP, một công ty đầu tư sở hữu khoảng 160 triệu USD cổ phiếu Nvidia, cho biết.

Với khả năng nạp ‘năng lượng’ cho các ứng dụng, một con chip trị giá khoảng 10.000 USD đang được coi là yếu tố quan trọng nhất nhì ngành trí tuệ nhân tạo: Nvidia A100.

Theo Nathan Benaich, một nhà đầu tư, A100 đã trở thành “con ngựa đầu tàu” vào thời điểm hiện tại. Công ty sản xuất ra nó hiện chiếm tới 95% thị trường bộ xử lý đồ họa sử dụng cho máy học.

Theo CNBC, A100 rất lý tưởng cho loại mô hình máy học hỗ trợ ChatGPT hoặc Bing AI. Việc nó có thể thực hiện đồng thời nhiều phép tính đơn giản được cho là có thể giúp ích cho việc đào tạo và sử dụng các mô hình mạng lưới thần kinh.

Công nghệ đằng sau A100 ban đầu được sử dụng để hiển thị đồ họa 3D phức tạp trong trò chơi. Nó thường được gọi là bộ xử lý đồ họa hoặc GPU, song ngày nay, A100 của Nvidia nhắm mục tiêu sang các tác vụ học máy và trung tâm dữ liệu chứ không đơn thuần chỉ là các PC trò chơi nữa. Các công ty lớn hoặc startup làm việc dựa trên chatbot và trình tạo hình ảnh sẽ cần hàng trăm hoặc hàng nghìn con chip trên của Nvidia.

Theo các chuyên gia, cần hàng trăm GPU để huấn luyện các mô hình trí tuệ nhân tạo. Các con chip cũng cần đủ mạnh để có thể xử lý dữ liệu một cách chính xác và nhanh chóng. Điều này đồng nghĩa với việc các công ty AI cần tiếp cận rất nhiều A100. Một số người còn coi số lượng A100 mà họ có quyền truy cập là chỉ dấu của sự tiến bộ.

Giám đốc điều hành Nvidia, Jensen Huang, không thể ngừng nói về AI trong cuộc trò chuyện với các nhà phân tích, đồng thời gợi ý rằng sự bùng nổ gần đây của trí tuệ nhân tạo chính là chiến lược của công ty.

“Hoạt động xoay quanh việc xây dựng cơ sở hạ tầng AI, sử dụng Hopper và Ampere nhằm tác động đến các mô hình ngôn ngữ lớn đã tăng vọt trong 60 ngày qua”, Huang nói. Được biết Ampere là tên mã dành cho thế hệ chip A100, còn Hopper là tên chip thế hệ mới H100.

Theo CNBC, các công ty khổng lồ về AI thường cần mua nhiều GPU để xử lý hoặc cải thiện mô hình. Nhiều trung tâm dữ liệu còn sử dụng hệ thống cao cấp hơn bao gồm 8 GPU A100 hoạt động cùng nhau.

Hệ thống này, DGX A100, có giá đề xuất gần 200.000 USD. Nvidia cho biết họ sẽ bán trực tiếp quyền truy cập đám mây cho các hệ thống DGX nhằm giảm chi phí đầu vào.

Theo một ước tính từ New Street Research, mô hình ChatGPT dựa trên OpenAI có thể yêu cầu 8 GPU để đưa ra câu trả lời trong vòng chưa đầy 1 giây. Với tốc độ đó, Microsoft sẽ cần hơn 20.000 máy chủ 8 GPU chỉ để triển khai Bing, tức tiêu tốn tới 4 tỷ USD.

“Nếu bạn đến từ Microsoft và muốn mở rộng quy mô, 4 tỷ USD là con số bạn cần phải bỏ ra. Còn nếu bạn muốn mở rộng theo quy mô của Google, nơi phục vụ 8 hoặc 9 tỷ truy vấn mỗi ngày, bạn sẽ phải chi 80 tỷ USD cho DGX”, Antoine Chkaiban, một nhà phân tích công nghệ tại New Street Research cho biết. “Những con số chúng tôi đưa ra rất lớn nhưng nó chỉ đơn giản phản ánh thực tế”.

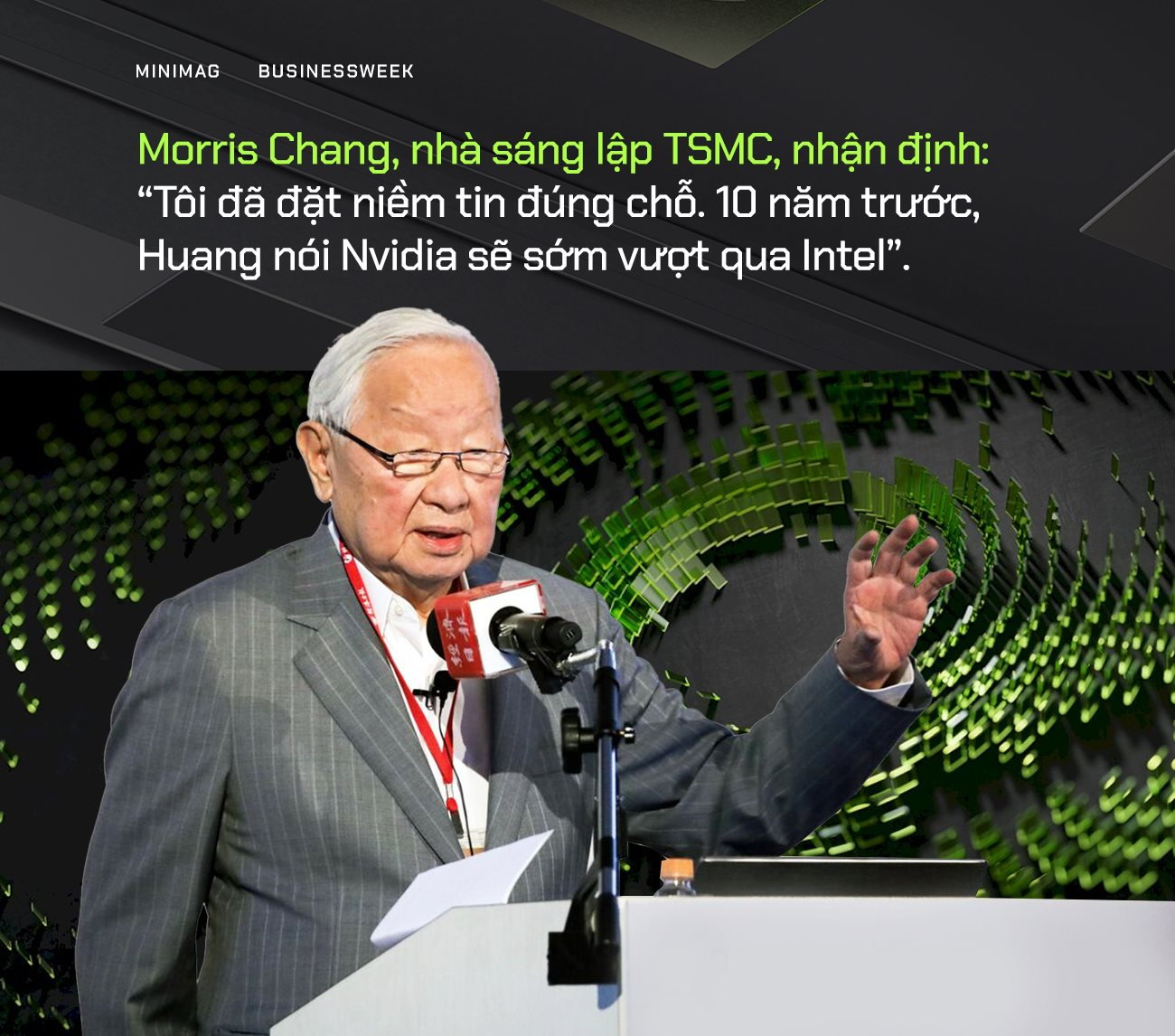

Tháng 7/2020, Nvidia được vinh danh là nhà sản xuất chip giá trị nhất của Mỹ. Morris Chang, nhà sáng lập TSMC, nhận định: “Tôi đã đặt niềm tin đúng chỗ. 10 năm trước, Huang nói Nvidia sẽ sớm vượt qua Intel”.

Tuy nhiên, việc Giám đốc điều hành Jensen Huang quảng bá về AI trong giai đoạn này không gây được nhiều tiếng vang. Mọi người khi đó đang bận tâm đến các trò chơi điện tử và cược lớn vào tiền số - thứ vô hình chung thúc đẩy nhu cầu đối với GPU Nvidia.

Huang cố gắng tận dụng nhưng bất thành, sau đó quyết định mua lại nhà thiết kế chip Arm. Hợp đồng trị giá 40 tỷ USD cuối cùng đã giúp Nvidia có chỗ đứng trong lĩnh vực công nghệ, đồng thời mở rộng phạm vi tiếp cận sang nhiều loại sản phẩm khác. Tuy nhiên, các công ty phụ thuộc vào chip nhớ của Arm đã cảnh giác với sức mạnh ngày càng tăng của Nvidia. Một số cố gắng tạo ra chip của riêng mình để giảm sự phụ thuộc song khó lòng đạt đến trình độ thiết kế và lập trình phức tạp.

Elon Musk nằm trong số đó. Năm 2018, người đàn ông này đã đã cố gắng thiết kế một con chip để thay thế nền tảng tự lái của Nvidia. Sarah Tariq, phó Chủ tịch phụ trách phần mềm lái xe tự hành của Nvidia, cho biết: “Đó là chiến lược của họ: tự làm chip và đại loại là sở hữu từ đầu đến cuối”.

Tiếc là Elon Musk vẫn phải phụ thuộc vào Nvidia. Mới đây, CEO Tesla đã phải đặt hàng nghìn GPU Nvidia để thực thực hóa một dự án AI tiềm năng.

Alphabet, Amazon và Microsoft đã đầu tư hàng tỷ USD vào chip nhớ. Google đã có những bước tiến đáng kể với các đơn vị xử lý tensor. Midjourney, ứng dụng tạo hình ảnh AI phổ biến, hiện đang sử dụng bộ xử lý của Google và GPU Nvidia. Tuy nhiên, một phân tích của New Street Research LLP cho thấy chip của Google kém linh hoạt hơn và không bền bằng Nvidia.

Phiên bản kế nhiệm của A100 — Hopper 100, được đặt theo tên của nhà lập trình tiên phong Grace Hopper, hiện đang được sản xuất và có hiệu suất tương đương chip nhớ của Google. Theo Pierre Ferragu, một nhà phân tích tại New Street, ngay cả những người quyền lực nhất trong ngành cũng kiêng nể trước Huang.

“Ai nấy đều sợ làm mất lòng Nvidia”, Pierre Ferragu nói.

Đáp lại, ông Huang từ chối các câu hỏi xoay quanh mối đe dọa đối với Nvidia. Vị giám đốc điều hành này không quan tâm liệu khách hàng của mình có trở thành đối thủ hay không, đồng thời khẳng định Google là một trong những đối tác cốt lõi.

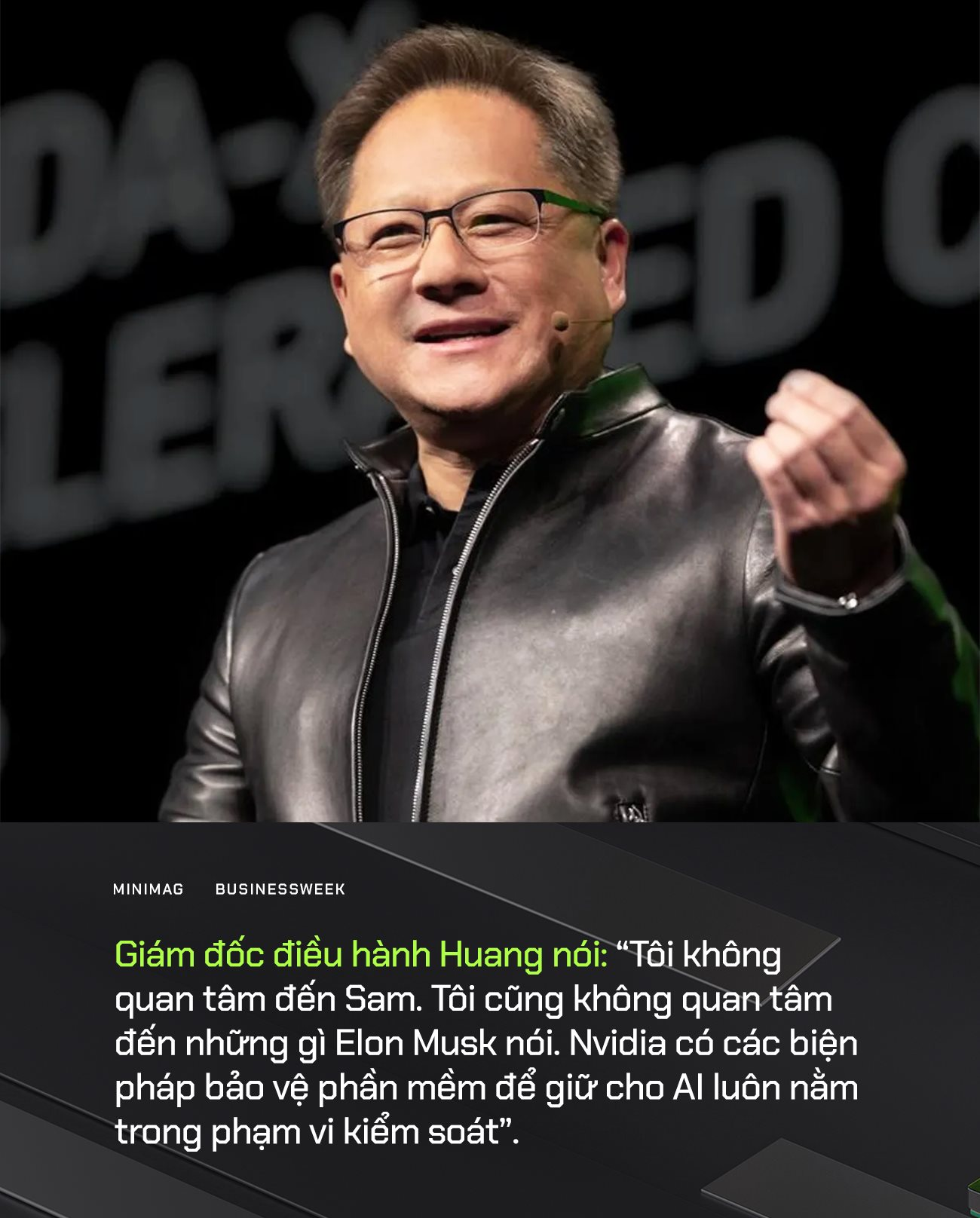

Mới đây, Đồng sáng lập Apple Steve Wozniak, Elon Musk cùng hơn 1.000 nhà lãnh đạo doanh nghiệp vừa ký một bức thư yêu cầu các biện pháp bảo mật và tạm dừng phát triển các mô hình AI trong bối cảnh công nghệ trí tuệ nhân tạo bùng nổ. Họ lập luận rằng các mô hình AI mạnh mẽ như GPT-4 của OpenAI chỉ nên phát triển nếu dành được sự tin tưởng và kiểm soát được toàn bộ rủi ro.

Đáp trả lại những lo ngại này, Giám đốc điều hành Huang nói: “Tôi không quan tâm đến Sam. Tôi cũng không quan tâm đến những gì Elon Musk nói. Nvidia có các biện pháp bảo vệ phần mềm để giữ cho AI luôn nằm trong phạm vi kiểm soát”.

Về phần mình, Huang cũng thừa nhận AI khiến ông ngạc nhiên nhiều hơn thay vì thất vọng hay quan ngại.

“Chúng tôi sợ mạng xã hội, nhưng chúng tôi không sợ AI”, Huang nhấn mạnh.

Lần đầu tiên dùng thử ChatGPT, Giám đốc điều hành Nvidia Jensen Huang yêu cầu chatbot này viết một bài thơ về công ty. Kết quả vượt ngoài sự mong đợi và người đàn ông khi ấy vô cùng hài lòng vì đã liều lĩnh đặt cược vào AI.

“Nvidia hoàn thành thách thức. Với sức mạnh AI, công ty đã vượt qua được giới hạn của công nghệ”, ông Jensen Huang nói.

Trong suốt 30 năm, chip Nvidia đóng vai trò quan trọng trong việc phát triển các trò chơi điện tử, song vẫn khiến Huang nghi ngờ về khả năng sàng lọc các tập dữ liệu khổng lồ AI yêu cầu. Để kiểm tra giải thuyết này, ông hướng dẫn nhóm của mình xây dựng một máy chủ được thiết kế cho AI và giao thử nghiệm chiếc đầu tiên vào năm 2016 cho Elon Musk và Sam Altman - nhà sáng lập OpenAI.

Được quảng cáo như một siêu máy tính AI, thiết bị trị giá 129.000 USD này có kích thước bằng một chiếc cặp, chứa 8 bộ xử lý đồ họa kết nối có thể giải quyết công việc trong 2 giờ đồng hồ thay vì 6 ngày như thường lệ.

OpenAI phát hành ChatGPT vào cuối năm ngoái, với “bộ não” chứa hơn 20.000 bộ xử lý đồ họa Nvidia. Microsoft cam kết tài trợ hơn 10 tỷ USD và điều này sẽ giúp trang trải chi phí ngày càng tăng trong quá trình phát triển. Altman, Giám đốc điều hành OpenAI, sẽ cần thêm hàng tấn chip Nvidia để đáp ứng nhu cầu.

Chip Nvidia đóng vai trò quan trọng trong cơ sở hạ tầng đám mây. Các nhà khai thác trung tâm dữ liệu đã cùng nhau chi 15 tỷ USD vào năm ngoái cho các đơn đặt hàng số lượng lớn với Nvidia. Doanh thu hàng quý từ các trung tâm dữ liệu, thứ mà Nvidia hiện gọi là “nhà máy AI”, đã tăng 14% lên mức kỷ lục 4,28 tỷ USD. Dự báo doanh số cũng tăng vượt ước tính cũng giúp Nvidia chạm mốc vốn hóa 1 nghìn tỷ USD.

Theo Bloomberg, Nvidia bất ngờ trở thành “người khổng lồ” quan trọng cho công nghệ chip nhớ. Công ty sở hữu 80% thị trường chip cao cấp và thời gian chờ cho một trong những bộ xử lý AI này hiện đã lên tới 8 tháng. Một số khách hàng lớn của Huang đã phải thiết kế chip tùy chỉnh của riêng mình để giảm sự phụ thuộc vào Nvidia.

“Nvidia phải vấp ngã vì một lý do nào đó thì các đối thủ cạnh tranh mới có cơ hội”, Chris Mack, nhà phân tích tại Harding Loevner LP, một công ty đầu tư sở hữu khoảng 160 triệu USD cổ phiếu Nvidia, cho biết.

Với khả năng nạp ‘năng lượng’ cho các ứng dụng, một con chip trị giá khoảng 10.000 USD đang được coi là yếu tố quan trọng nhất nhì ngành trí tuệ nhân tạo: Nvidia A100.

Theo Nathan Benaich, một nhà đầu tư, A100 đã trở thành “con ngựa đầu tàu” vào thời điểm hiện tại. Công ty sản xuất ra nó hiện chiếm tới 95% thị trường bộ xử lý đồ họa sử dụng cho máy học.

Theo CNBC, A100 rất lý tưởng cho loại mô hình máy học hỗ trợ ChatGPT hoặc Bing AI. Việc nó có thể thực hiện đồng thời nhiều phép tính đơn giản được cho là có thể giúp ích cho việc đào tạo và sử dụng các mô hình mạng lưới thần kinh.

Công nghệ đằng sau A100 ban đầu được sử dụng để hiển thị đồ họa 3D phức tạp trong trò chơi. Nó thường được gọi là bộ xử lý đồ họa hoặc GPU, song ngày nay, A100 của Nvidia nhắm mục tiêu sang các tác vụ học máy và trung tâm dữ liệu chứ không đơn thuần chỉ là các PC trò chơi nữa. Các công ty lớn hoặc startup làm việc dựa trên chatbot và trình tạo hình ảnh sẽ cần hàng trăm hoặc hàng nghìn con chip trên của Nvidia.

Theo các chuyên gia, cần hàng trăm GPU để huấn luyện các mô hình trí tuệ nhân tạo. Các con chip cũng cần đủ mạnh để có thể xử lý dữ liệu một cách chính xác và nhanh chóng. Điều này đồng nghĩa với việc các công ty AI cần tiếp cận rất nhiều A100. Một số người còn coi số lượng A100 mà họ có quyền truy cập là chỉ dấu của sự tiến bộ.

Giám đốc điều hành Nvidia, Jensen Huang, không thể ngừng nói về AI trong cuộc trò chuyện với các nhà phân tích, đồng thời gợi ý rằng sự bùng nổ gần đây của trí tuệ nhân tạo chính là chiến lược của công ty.

“Hoạt động xoay quanh việc xây dựng cơ sở hạ tầng AI, sử dụng Hopper và Ampere nhằm tác động đến các mô hình ngôn ngữ lớn đã tăng vọt trong 60 ngày qua”, Huang nói. Được biết Ampere là tên mã dành cho thế hệ chip A100, còn Hopper là tên chip thế hệ mới H100.

Theo CNBC, các công ty khổng lồ về AI thường cần mua nhiều GPU để xử lý hoặc cải thiện mô hình. Nhiều trung tâm dữ liệu còn sử dụng hệ thống cao cấp hơn bao gồm 8 GPU A100 hoạt động cùng nhau.

Hệ thống này, DGX A100, có giá đề xuất gần 200.000 USD. Nvidia cho biết họ sẽ bán trực tiếp quyền truy cập đám mây cho các hệ thống DGX nhằm giảm chi phí đầu vào.

Theo một ước tính từ New Street Research, mô hình ChatGPT dựa trên OpenAI có thể yêu cầu 8 GPU để đưa ra câu trả lời trong vòng chưa đầy 1 giây. Với tốc độ đó, Microsoft sẽ cần hơn 20.000 máy chủ 8 GPU chỉ để triển khai Bing, tức tiêu tốn tới 4 tỷ USD.

“Nếu bạn đến từ Microsoft và muốn mở rộng quy mô, 4 tỷ USD là con số bạn cần phải bỏ ra. Còn nếu bạn muốn mở rộng theo quy mô của Google, nơi phục vụ 8 hoặc 9 tỷ truy vấn mỗi ngày, bạn sẽ phải chi 80 tỷ USD cho DGX”, Antoine Chkaiban, một nhà phân tích công nghệ tại New Street Research cho biết. “Những con số chúng tôi đưa ra rất lớn nhưng nó chỉ đơn giản phản ánh thực tế”.

Tháng 7/2020, Nvidia được vinh danh là nhà sản xuất chip giá trị nhất của Mỹ. Morris Chang, nhà sáng lập TSMC, nhận định: “Tôi đã đặt niềm tin đúng chỗ. 10 năm trước, Huang nói Nvidia sẽ sớm vượt qua Intel”.

Tuy nhiên, việc Giám đốc điều hành Jensen Huang quảng bá về AI trong giai đoạn này không gây được nhiều tiếng vang. Mọi người khi đó đang bận tâm đến các trò chơi điện tử và cược lớn vào tiền số - thứ vô hình chung thúc đẩy nhu cầu đối với GPU Nvidia.

Huang cố gắng tận dụng nhưng bất thành, sau đó quyết định mua lại nhà thiết kế chip Arm. Hợp đồng trị giá 40 tỷ USD cuối cùng đã giúp Nvidia có chỗ đứng trong lĩnh vực công nghệ, đồng thời mở rộng phạm vi tiếp cận sang nhiều loại sản phẩm khác. Tuy nhiên, các công ty phụ thuộc vào chip nhớ của Arm đã cảnh giác với sức mạnh ngày càng tăng của Nvidia. Một số cố gắng tạo ra chip của riêng mình để giảm sự phụ thuộc song khó lòng đạt đến trình độ thiết kế và lập trình phức tạp.

Elon Musk nằm trong số đó. Năm 2018, người đàn ông này đã đã cố gắng thiết kế một con chip để thay thế nền tảng tự lái của Nvidia. Sarah Tariq, phó Chủ tịch phụ trách phần mềm lái xe tự hành của Nvidia, cho biết: “Đó là chiến lược của họ: tự làm chip và đại loại là sở hữu từ đầu đến cuối”.

Tiếc là Elon Musk vẫn phải phụ thuộc vào Nvidia. Mới đây, CEO Tesla đã phải đặt hàng nghìn GPU Nvidia để thực thực hóa một dự án AI tiềm năng.

Alphabet, Amazon và Microsoft đã đầu tư hàng tỷ USD vào chip nhớ. Google đã có những bước tiến đáng kể với các đơn vị xử lý tensor. Midjourney, ứng dụng tạo hình ảnh AI phổ biến, hiện đang sử dụng bộ xử lý của Google và GPU Nvidia. Tuy nhiên, một phân tích của New Street Research LLP cho thấy chip của Google kém linh hoạt hơn và không bền bằng Nvidia.

Phiên bản kế nhiệm của A100 — Hopper 100, được đặt theo tên của nhà lập trình tiên phong Grace Hopper, hiện đang được sản xuất và có hiệu suất tương đương chip nhớ của Google. Theo Pierre Ferragu, một nhà phân tích tại New Street, ngay cả những người quyền lực nhất trong ngành cũng kiêng nể trước Huang.

“Ai nấy đều sợ làm mất lòng Nvidia”, Pierre Ferragu nói.

Đáp lại, ông Huang từ chối các câu hỏi xoay quanh mối đe dọa đối với Nvidia. Vị giám đốc điều hành này không quan tâm liệu khách hàng của mình có trở thành đối thủ hay không, đồng thời khẳng định Google là một trong những đối tác cốt lõi.

Mới đây, Đồng sáng lập Apple Steve Wozniak, Elon Musk cùng hơn 1.000 nhà lãnh đạo doanh nghiệp vừa ký một bức thư yêu cầu các biện pháp bảo mật và tạm dừng phát triển các mô hình AI trong bối cảnh công nghệ trí tuệ nhân tạo bùng nổ. Họ lập luận rằng các mô hình AI mạnh mẽ như GPT-4 của OpenAI chỉ nên phát triển nếu dành được sự tin tưởng và kiểm soát được toàn bộ rủi ro.

Đáp trả lại những lo ngại này, Giám đốc điều hành Huang nói: “Tôi không quan tâm đến Sam. Tôi cũng không quan tâm đến những gì Elon Musk nói. Nvidia có các biện pháp bảo vệ phần mềm để giữ cho AI luôn nằm trong phạm vi kiểm soát”.

Về phần mình, Huang cũng thừa nhận AI khiến ông ngạc nhiên nhiều hơn thay vì thất vọng hay quan ngại.

“Chúng tôi sợ mạng xã hội, nhưng chúng tôi không sợ AI”, Huang nhấn mạnh.

Theo Genk