TS. Nguyễn Thanh Tùng, nhà khoa học người Việt làm việc lâu năm ở Mỹ, chia sẻ về quá trình xây dựng "bài kiểm tra cuối cùng của loài người" để đánh giá năng lực AI.

AI đã phát triển đến một trình độ đáng kinh ngạc. Nó có thể viết mã như những lập trình viên giỏi nhất, giải toán với trình độ tương đương huy chương bạc Olympic Toán quốc tế, hay đạt kết quả xuất sắc trong các bài kiểm tra chuẩn hóa như SAT hay GRE. Nhưng liệu AI thực sự hiểu thế giới như con người? Nó có khả năng tư duy như một chuyên gia hàng đầu không?

Đây là những câu hỏi then chốt dẫn đến sự ra đời của Humanity’s Last Exam (HLE, tạm dịch "Bài kiểm tra cuối cùng của loài người"), cũng là bài kiểm tra khó nhất dành cho AI hiện nay.

TS. Nguyễn Thanh Tùng, Phó Giáo sư Chuyên giảng tại Đại học Texas A&M, hiện làm việc tại Việt Nam với tư cách là Giảng viên cao cấp tại Đại học Fulbright, nhà khoa học AI tại FPT, là một trong những người đóng góp nhiều nhất cho HLE.

Anh đã viết hơn 100 câu hỏi, trong đó có 70 câu được chọn vào bài kiểm tra chính thức. Trong lĩnh vực khoa học máy tính và AI, anh là người đóng góp số một về số lượng câu hỏi được chọn.

"Bài kiểm tra cuối cùng loài người" dành cho AI

Humanity’s Last Exam không đơn thuần là một bộ đề kiểm tra AI thông thường. Được tổ chức bởi Center for AI Safety và công ty Scale AI, bài kiểm tra này tập hợp 3.000 câu hỏi khó nhất đến từ hơn 500 chuyên gia hàng đầu thế giới.Các câu hỏi bao trùm hơn 100 lĩnh vực khác nhau như khoa học máy tính, toán học, vật lý, sinh học, hay nghệ thuật, triết học. Bộ câu hỏi có trình độ tiến sĩ, đòi hỏi kiến thức chuyên sâu và tư duy logic phức tạp.

Chia sẻ với Tri thức - Znews, TS. Nguyễn Thanh Tùng cho biết một trong những mô hình có kết quả tốt nhất trên HLE tính đến nay là o3 Deep Search của OpenAI, đạt hơn 25% số điểm khi làm bài thi theo hình thức “mở sách, mở máy”.

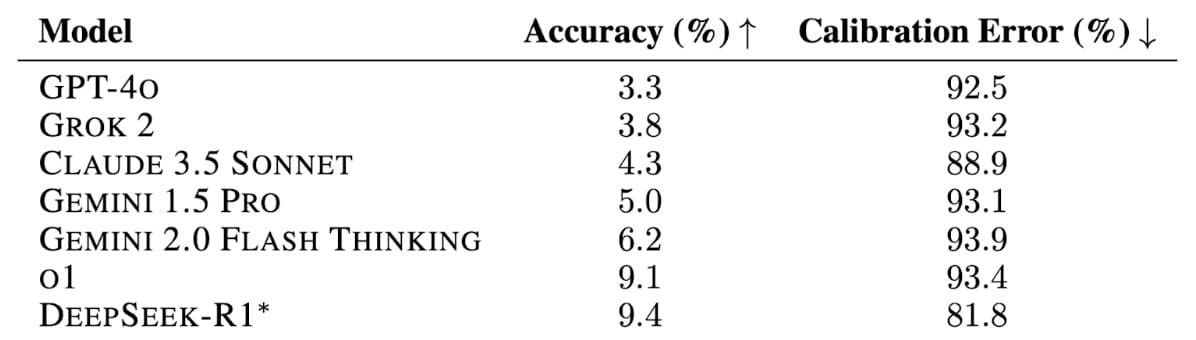

“Tức là được phép sử dụng công cụ tìm kiếm để tra cứu và Python để thực hiện các phép tính toán”, anh giải thích. Còn nếu chỉ dựa vào chính khả năng của mình, các AI hàng đầu cũng chỉ đạt dưới 10% tổng số điểm.

|

| Ngay cả các mô hình tiên tiến nhất hiện nay cũng chỉ đạt chưa đến 10% độ chính xác trong bài kiểm tra HLE. |

TS. Tùng cho hay mình bắt đầu tham gia đóng góp câu hỏi cho HLE từ tháng 9/2024. Đó là thời điểm chương trình mở đợt kêu gọi các chuyên gia toàn cầu. Để khuyến khích, tổ chức đã dành 500.000 USD làm phần thưởng cho những câu hỏi xuất sắc. Mức thưởng lên tới 5.000 USD cho 50 câu hỏi được đánh giá cao nhất và 500 USD cho 500 câu hỏi tiếp theo.

Những câu hỏi của TS. Tùng đều phải vượt qua nhiều vòng kiểm duyệt nghiêm ngặt. Đầu tiên, câu hỏi sẽ được thử nghiệm trên các mô hình AI tiên tiến nhất. Trong đó, trước hết, câu hỏi sẽ được 3 mô hình AI cơ bản kiểm tra. Nếu tất cả đều trả lời sai, nó sẽ được gửi đến 2 mô hình AI nâng cao hơn. Nếu không có mô hình nào trả lời đúng, câu hỏi mới vượt qua vòng sơ loại.

“Sau đó, câu hỏi được bình duyệt bởi 2 vòng, bởi nhóm chuyên gia hàng đầu, rồi lại chọn tiếp vào danh sách 3.000 câu hỏi chính thức. Sau khi công bố, bài thi tiếp tục được đánh giá công khai, chỉnh sửa các câu hỏi dựa trên góp ý của công chúng”, PGS TS tại Đại học Texas A&M giải thích.

Tính đến thời điểm hiện tại, TS. Tùng đã đóng góp hơn 100 câu hỏi, trong đó có 70 câu được chọn vào bài thi chính thức. Cả 70 câu hỏi đều không có mô hình AI nào trả lời đúng. Anh trở thành người đóng góp đứng thứ 2 về tổng số câu hỏi được chấp nhận và đứng đầu trong lĩnh vực khoa học máy tính, AI.